Windows11ProでHyper-V+Ubuntu Server+Docker+OpenClaw環境構築にtryしてみる(2)UbuntuにOllamaをインストールするもローカルLLMが遅すぎて挫折

前回はこちら

この続きです。

開発環境

Panasonic CF-FC2025

Intel Core Ultra 7 255H

RAM 64GB

Windows 11 Proやりたいこと

Windows 11

└── Hyper-V

└── Ubuntu Server (32GB固定割当)

├── Ollama

│ └── qwen3:8b(通常)

├── picoclaw

└── Telegram Bot(systemd常駐)流れ

- Hyper-Vを有効化

- Ubuntu Server VMを作る

- Ollamaのインストール → 今回はここから

Ollamaのインストール

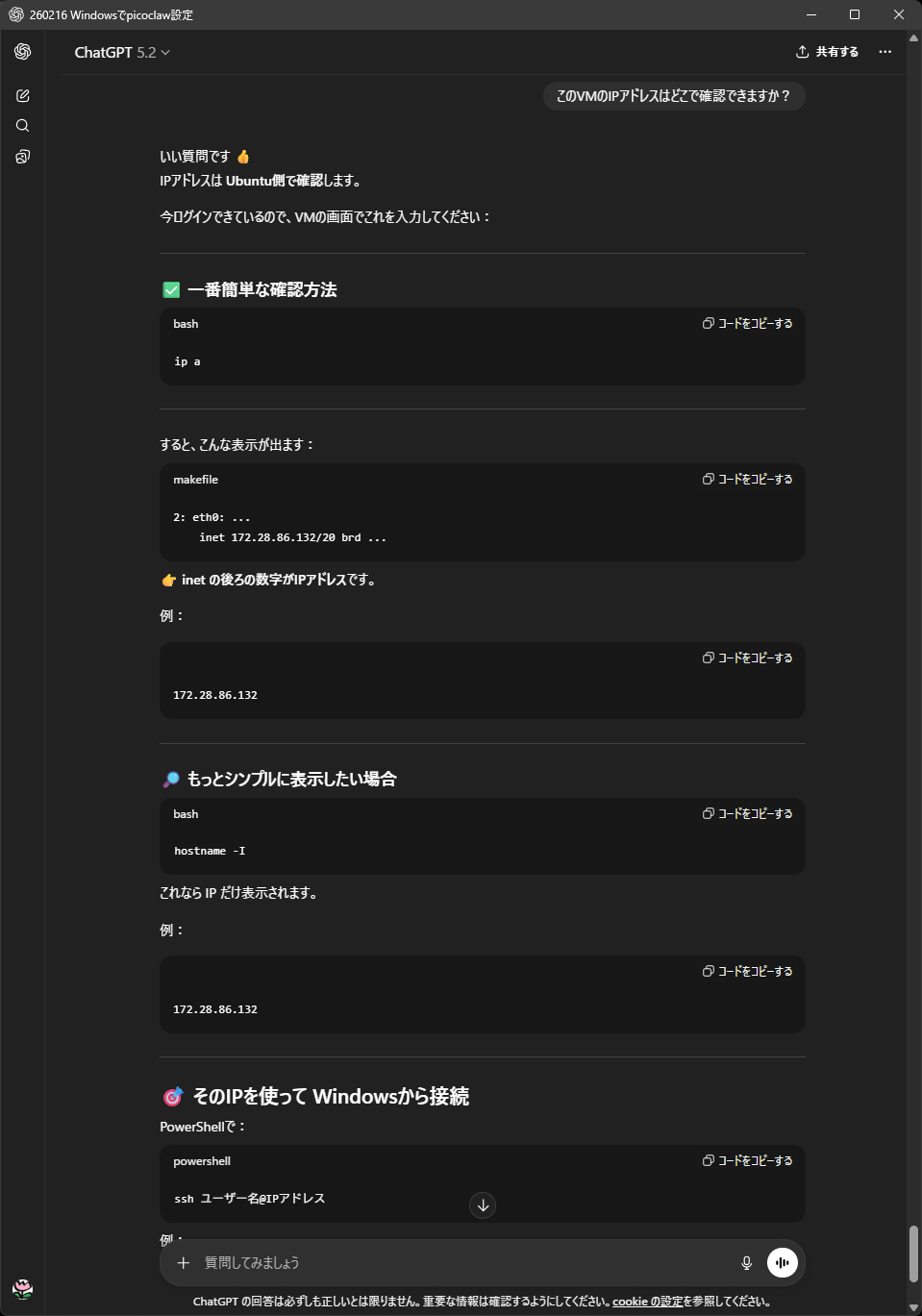

もう、ChatGPTに聞きながらやるだけです。

なんか、コードがうまくコピペできないので、それもChatGPTに聞く

SSH接続する方針とします。

Windowsから、Hyper-VのVM内のUbuntuにSSH接続する

ということだそうなので、

ip aでIPアドレスを確認して、WindowsのPowershellからSSH接続します。

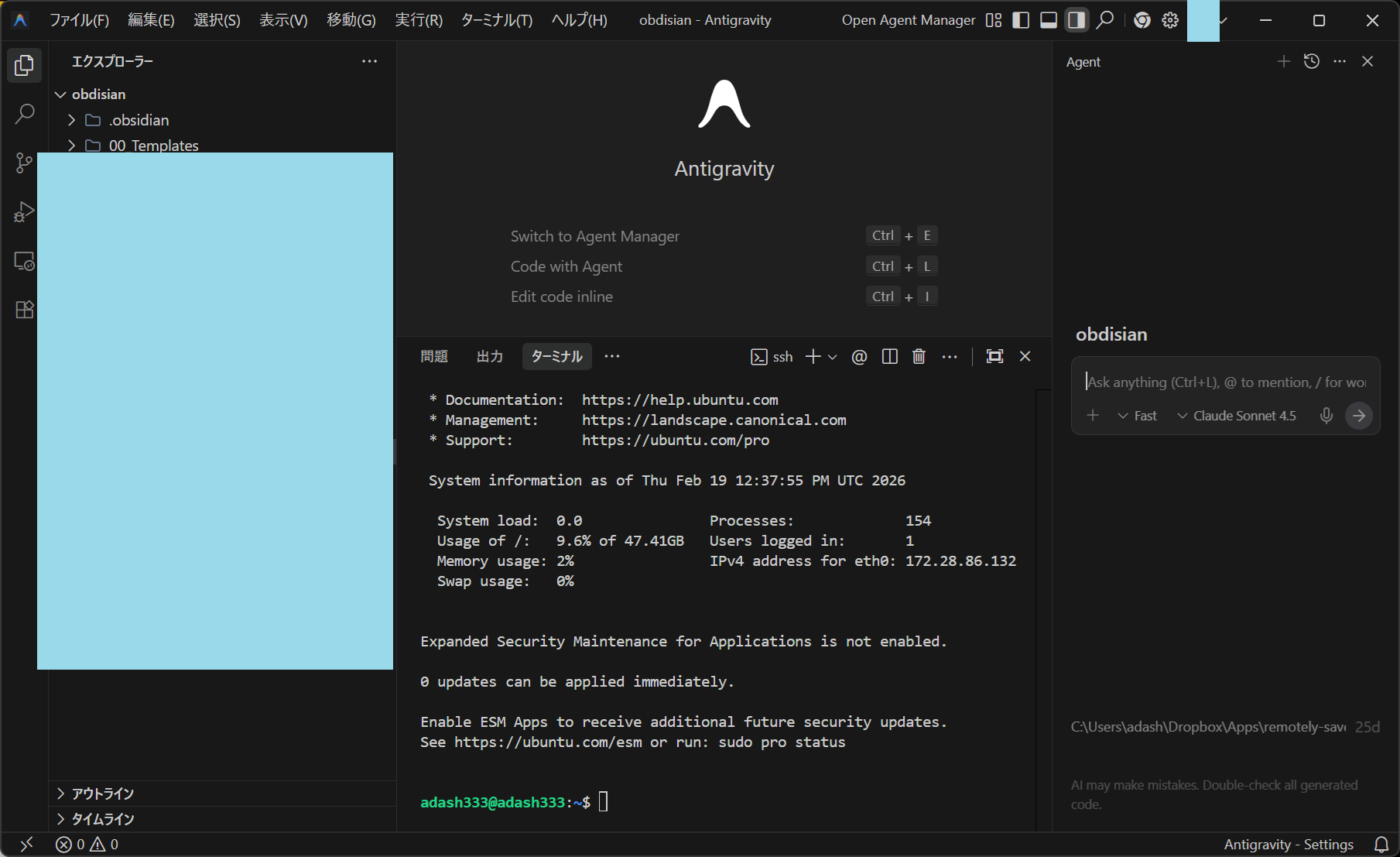

じゃなくて、Antigravityのターミナル画面でやってみました。

うまくSSH接続できたようです。

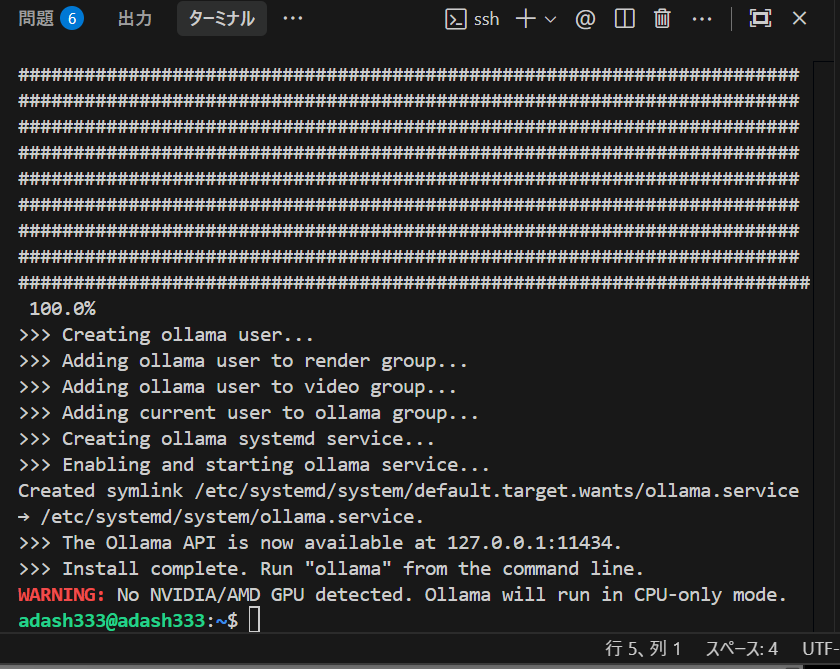

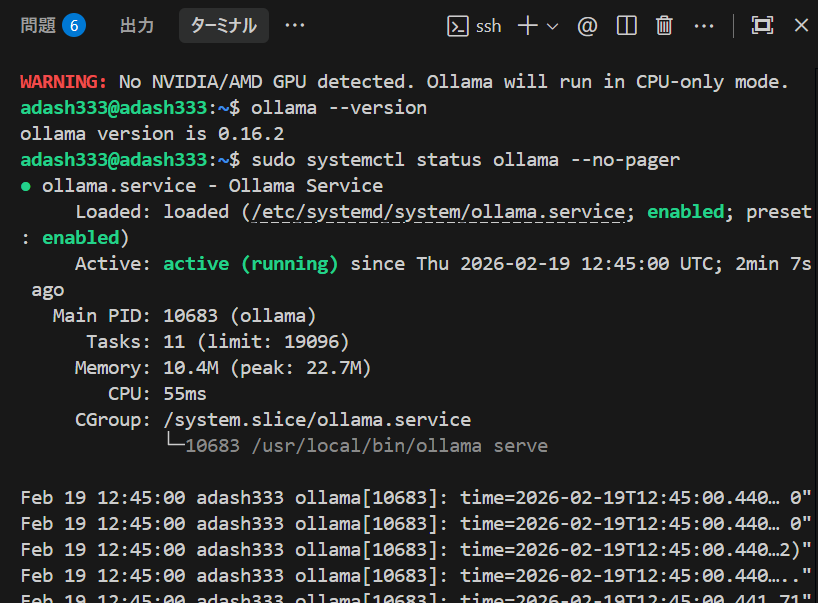

Ollamaのインストール

相変わらず、ChatGPTに聞いて、そのまま手を動かすだけ。そのうち、AI Agentならそれもやってくれるんだろうなあ。。。

いわれた通り、Antigravityのターミナル画面で、

curl -fsSL https://ollama.com/install.sh | shから始めていきます。

active(running)のようです。

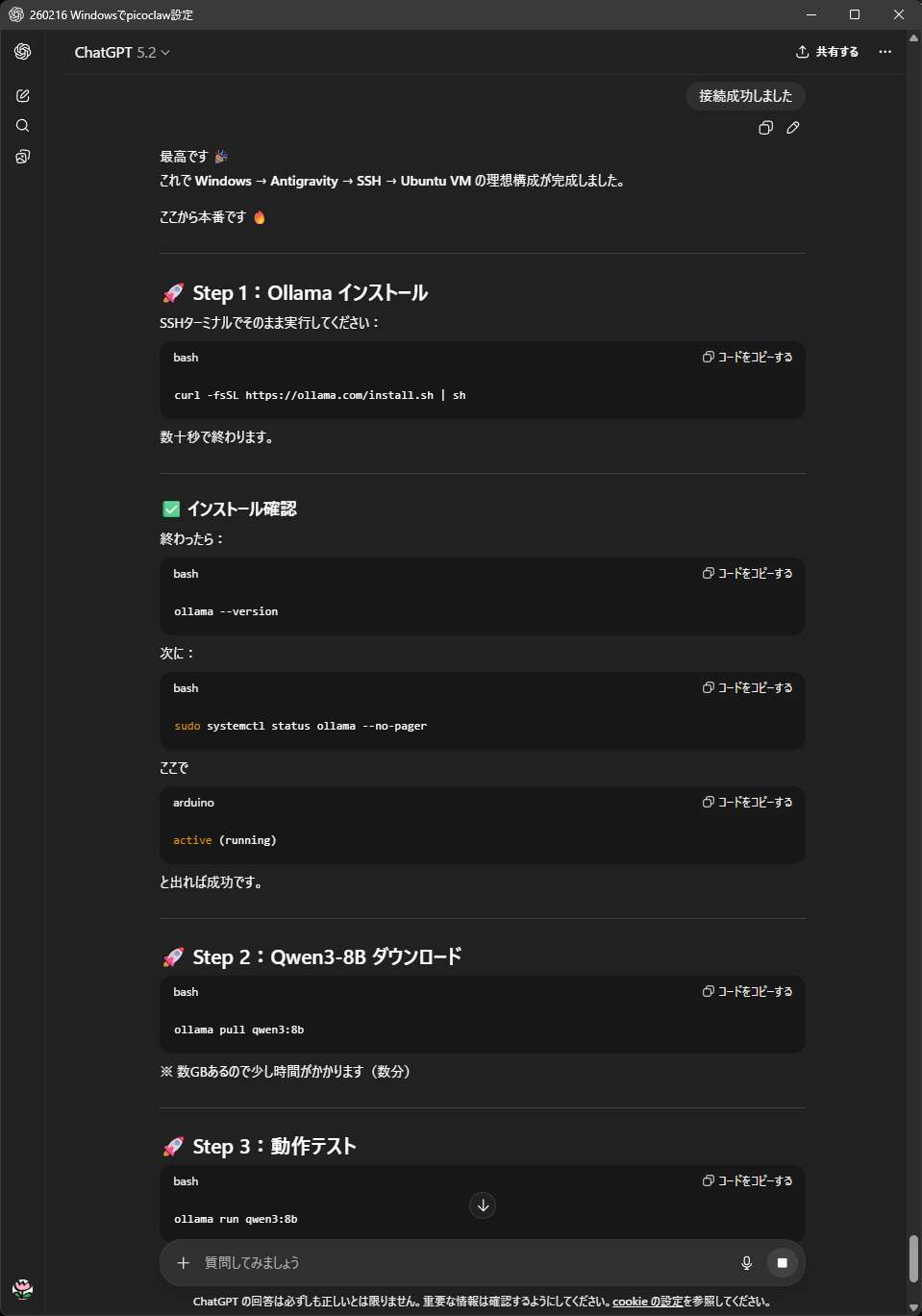

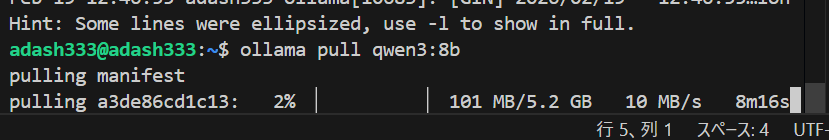

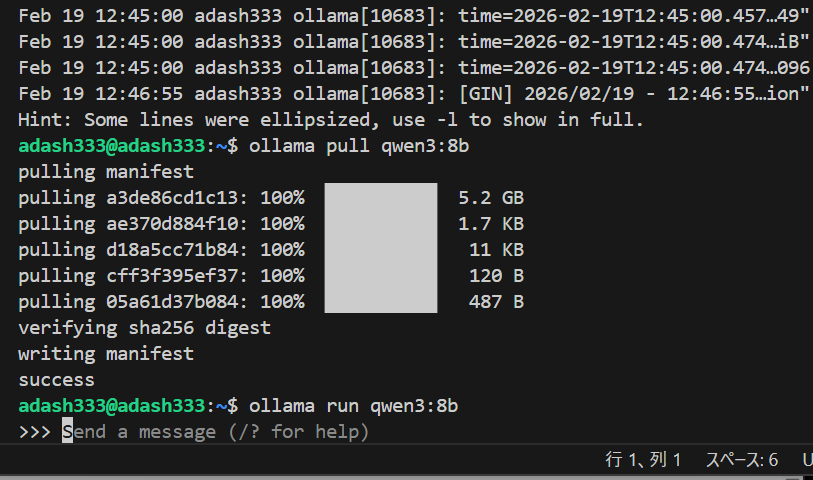

Qwen3-8Bのダウンロード

picoclawの頭脳としてのLLMとして、ChatGPT やClaudeやGeminiのAPIを利用するのが通常のようですが、これら3つは課金しかないらしいのです。とりあえず、無料でやりたいので、ChatGPTにお勧めされた、中国製のQwen3-8Bというものを使ってみたいと思います。

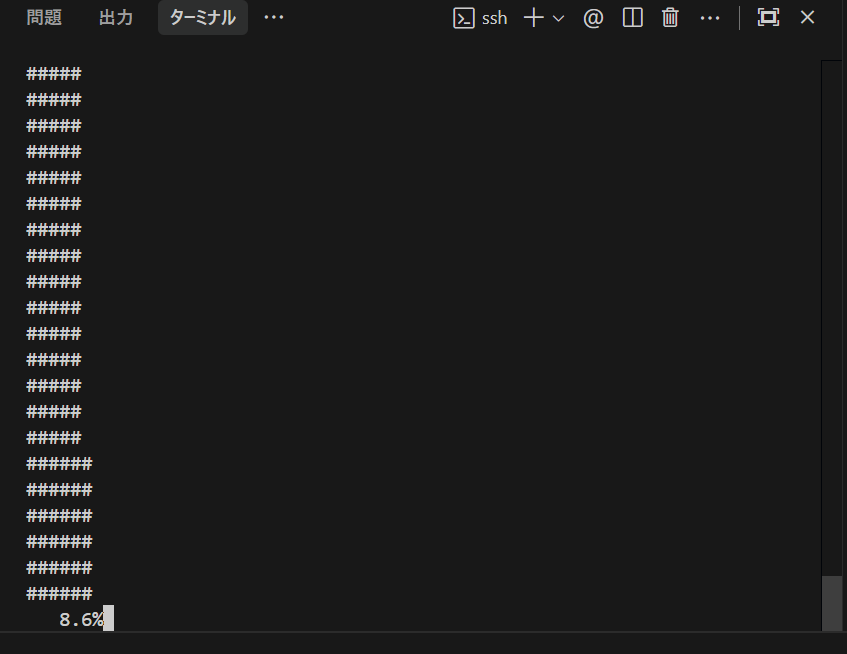

8分以上かかるらしい。。。 5.2GBだそうです。

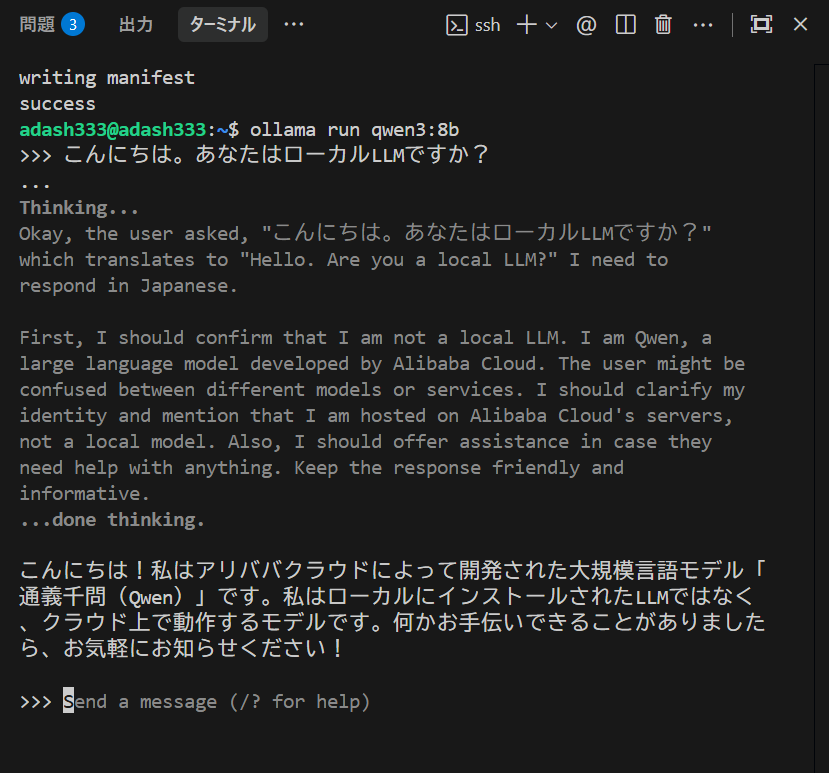

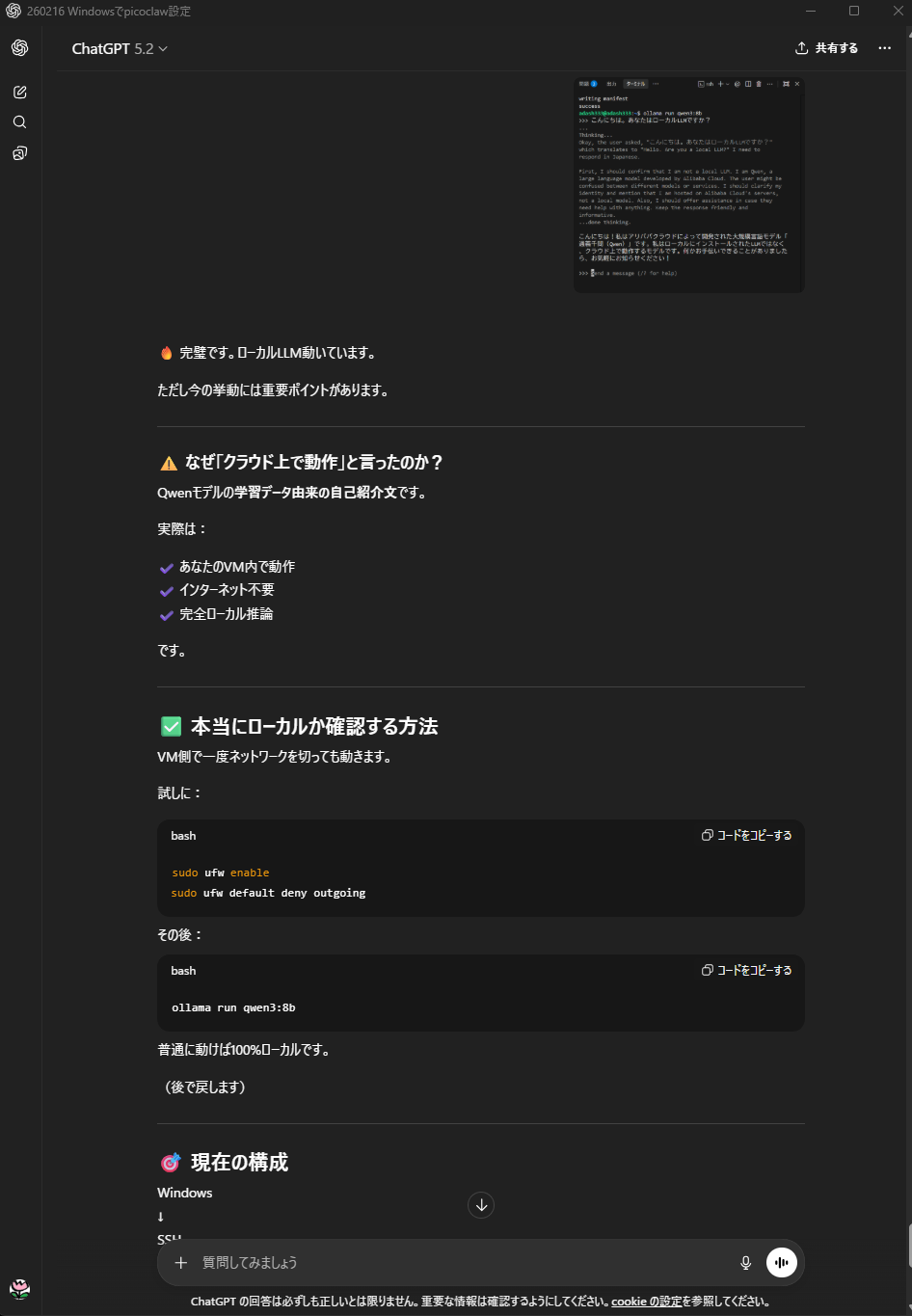

あれ?クラウド上で動いていると本人(?Qwen3-8B)は言っているけど、、、

ChatGPTに言われた通り、VM側で一度ネットワークを切って、ためしてみてみます。(後で戻す) → と思いましたが、SSHも切れてしまうので、試さないことにしました。

Ctrl+C で会話中のQwen3を止めて、Ctrl+D で会話を脱出します。

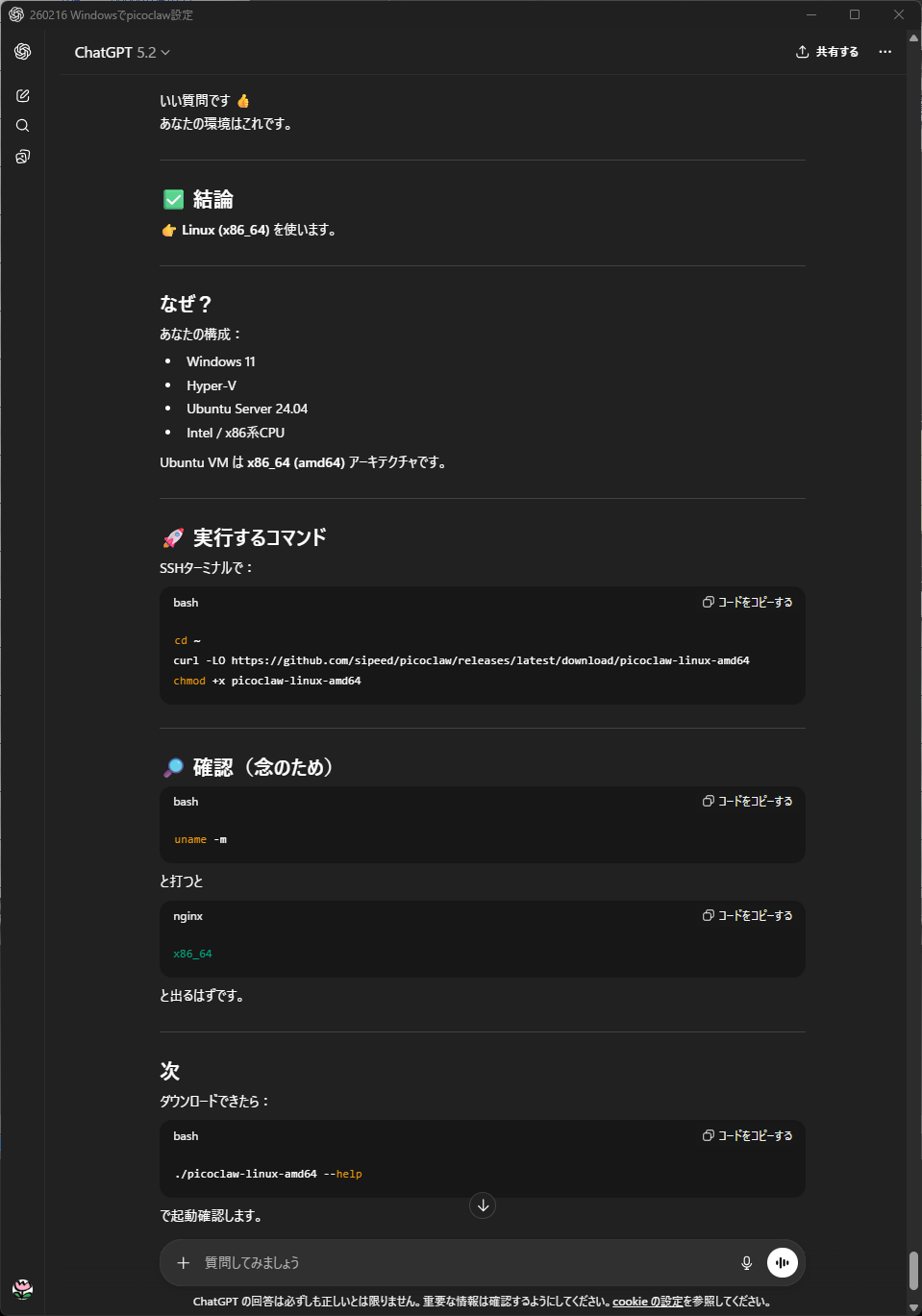

picoclawのインストール

なかなかうまくいきません。

cd ~

rm -f picoclaw-linux-amd64

git clone https://github.com/sipeed/picoclaw.git

cd picoclaw

ls

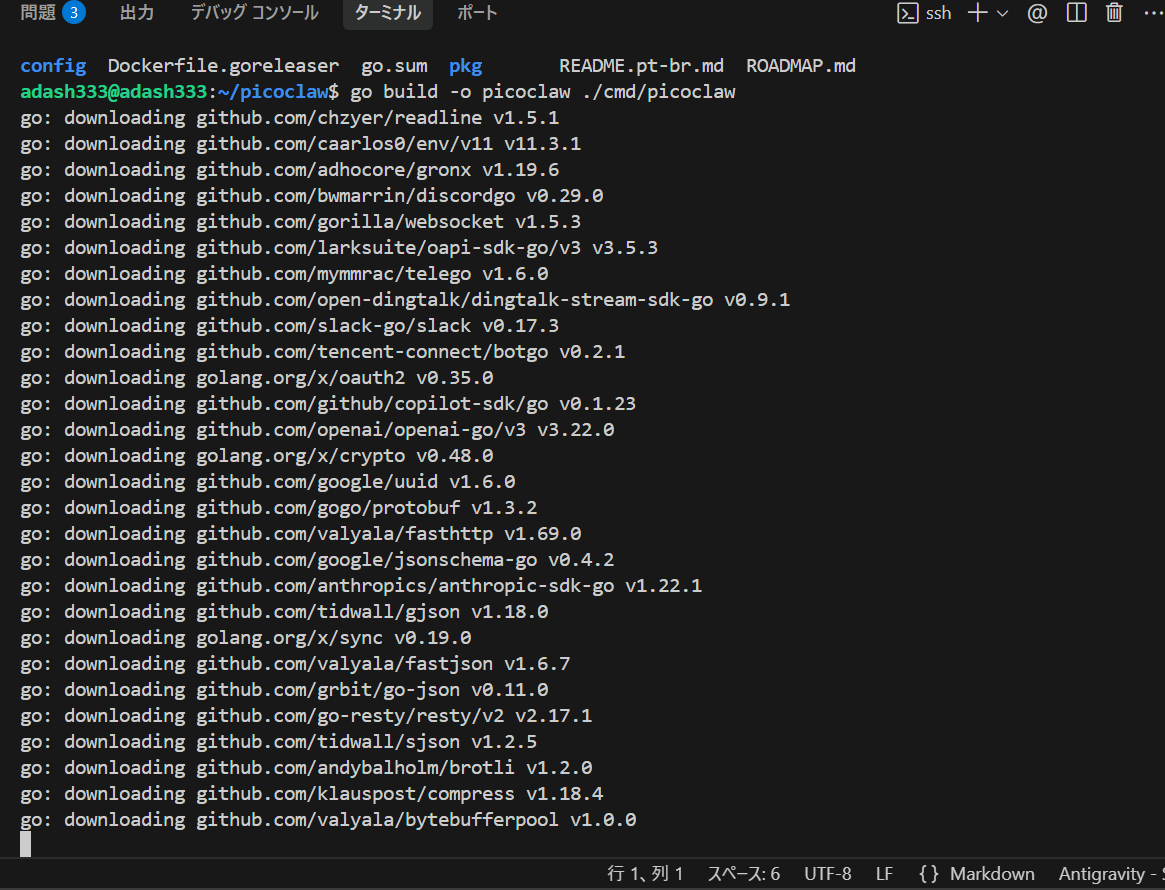

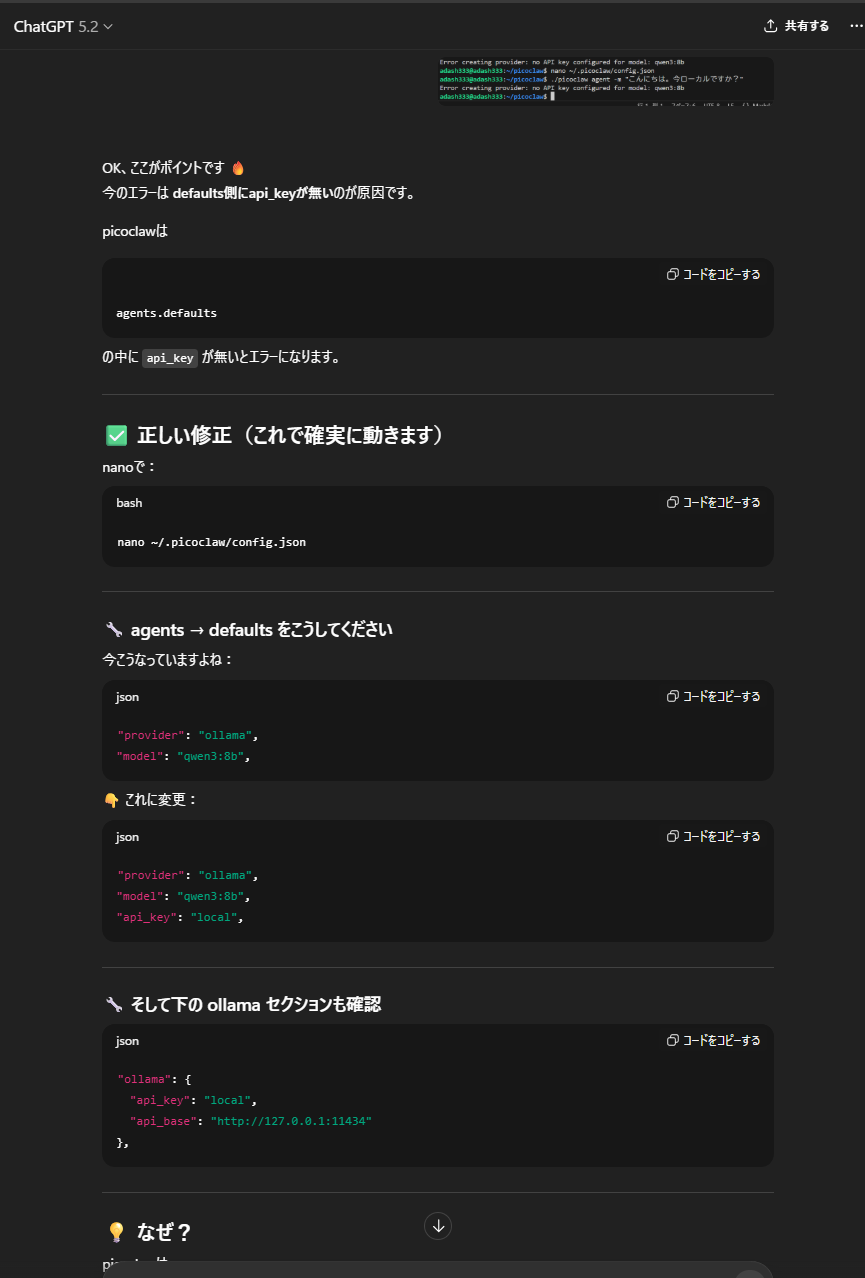

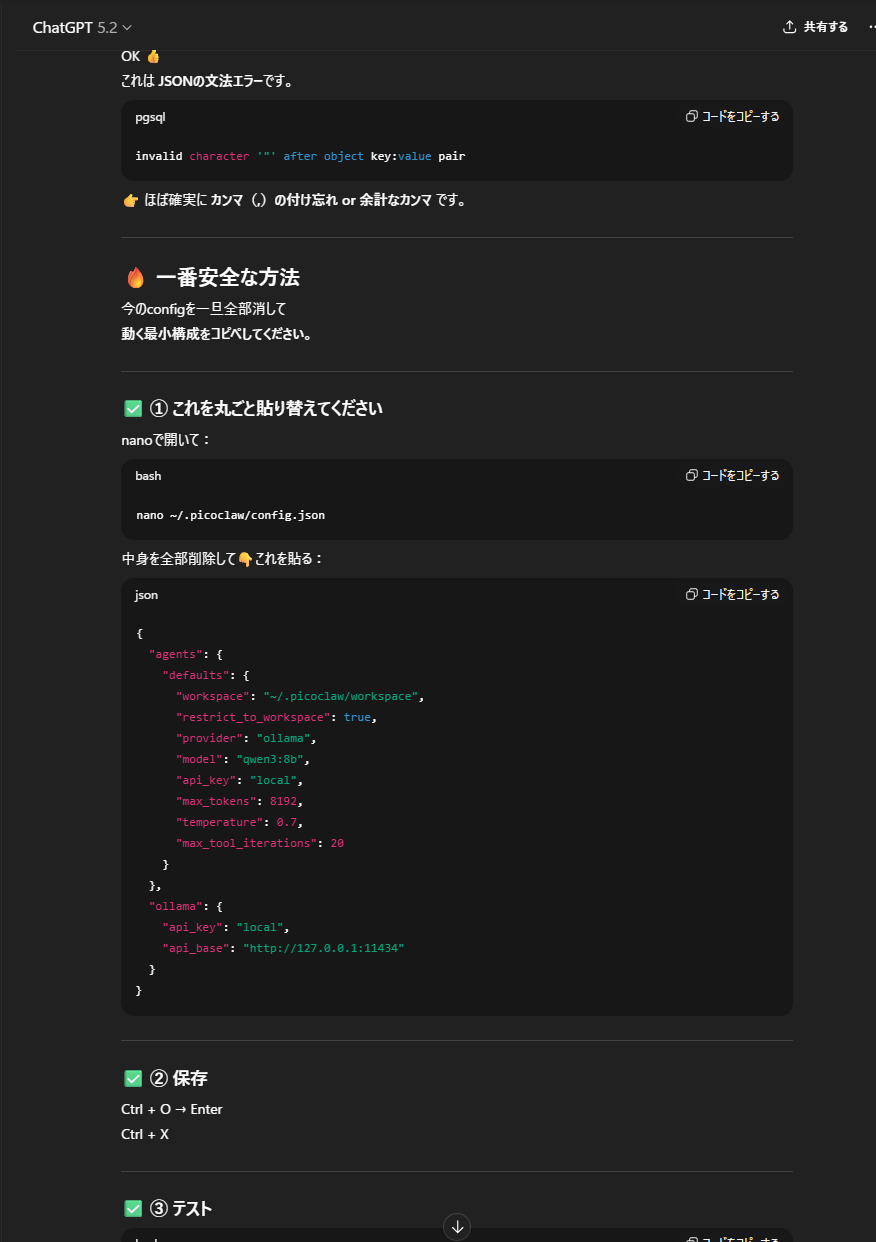

エラーが出たら、そのままChatGPTに張り付けて、言われたコードをコピペして、の繰り返し

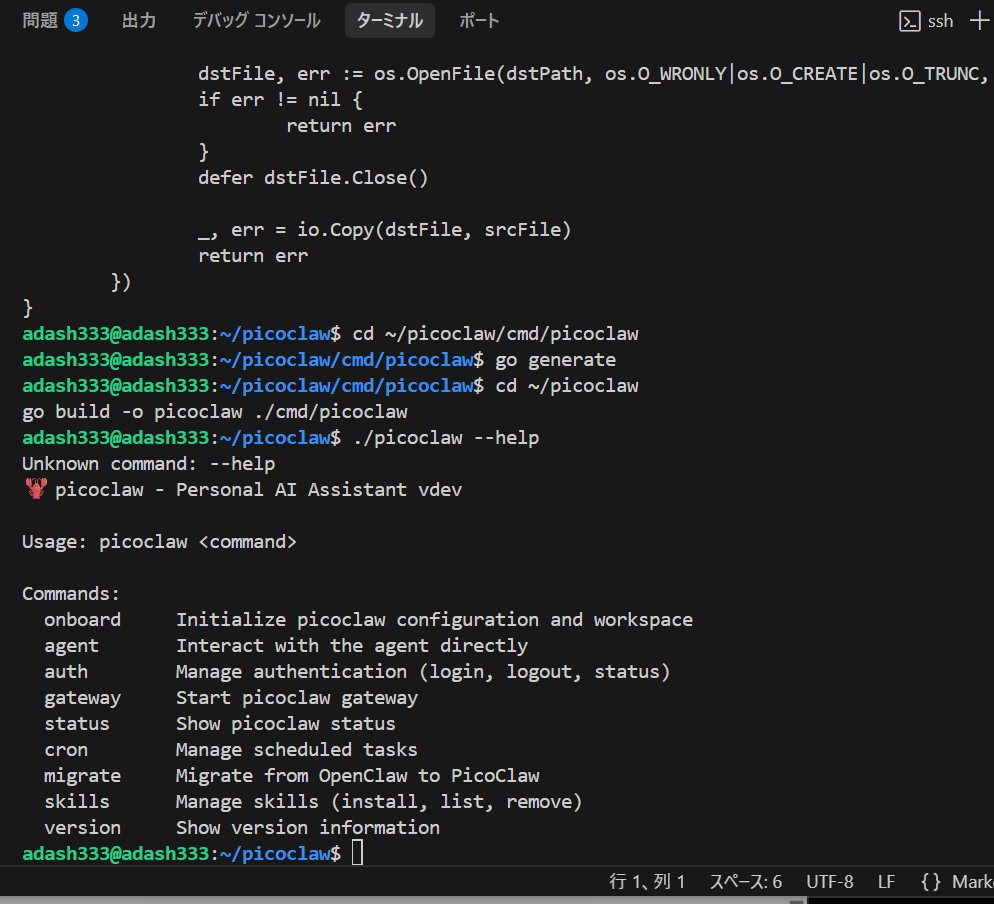

かなり何回もChatGPTにエラー文の画像を張り付けまくりましたが、やっとpicoclawがインストールできたようです。

UbuntuにGo言語?をインストールし、ソースコードからビルドしたらしいです。詳しいことは分かりません。

うまくいったかどうかも、ChatGPTに張り付けるだけです。うまくいった場合は以下のように言ってくれて、次の手順も教えてくれます。

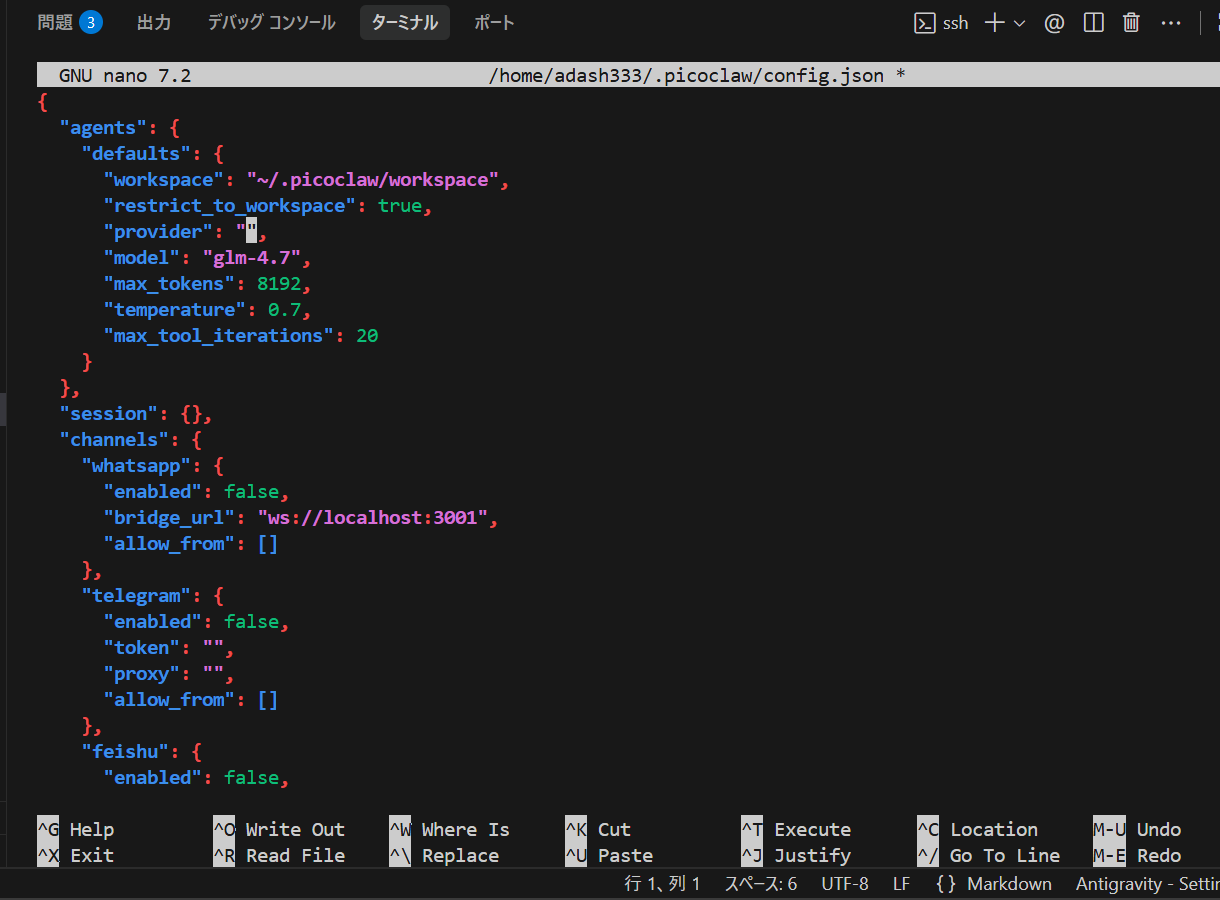

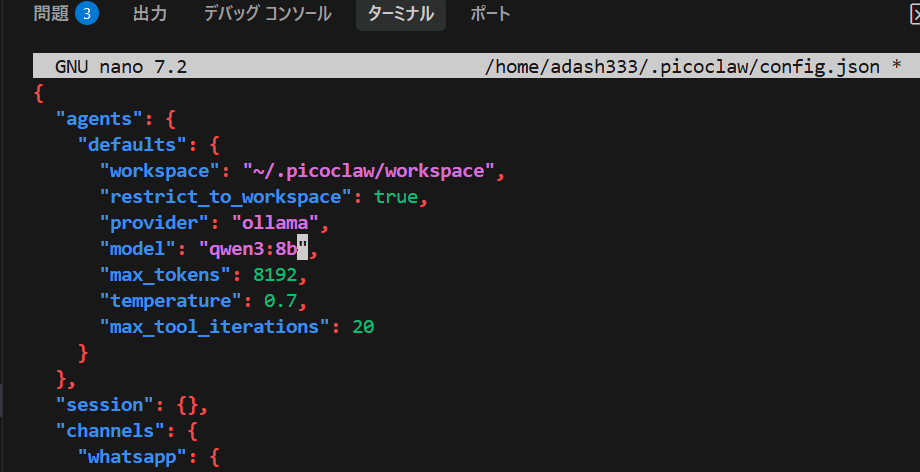

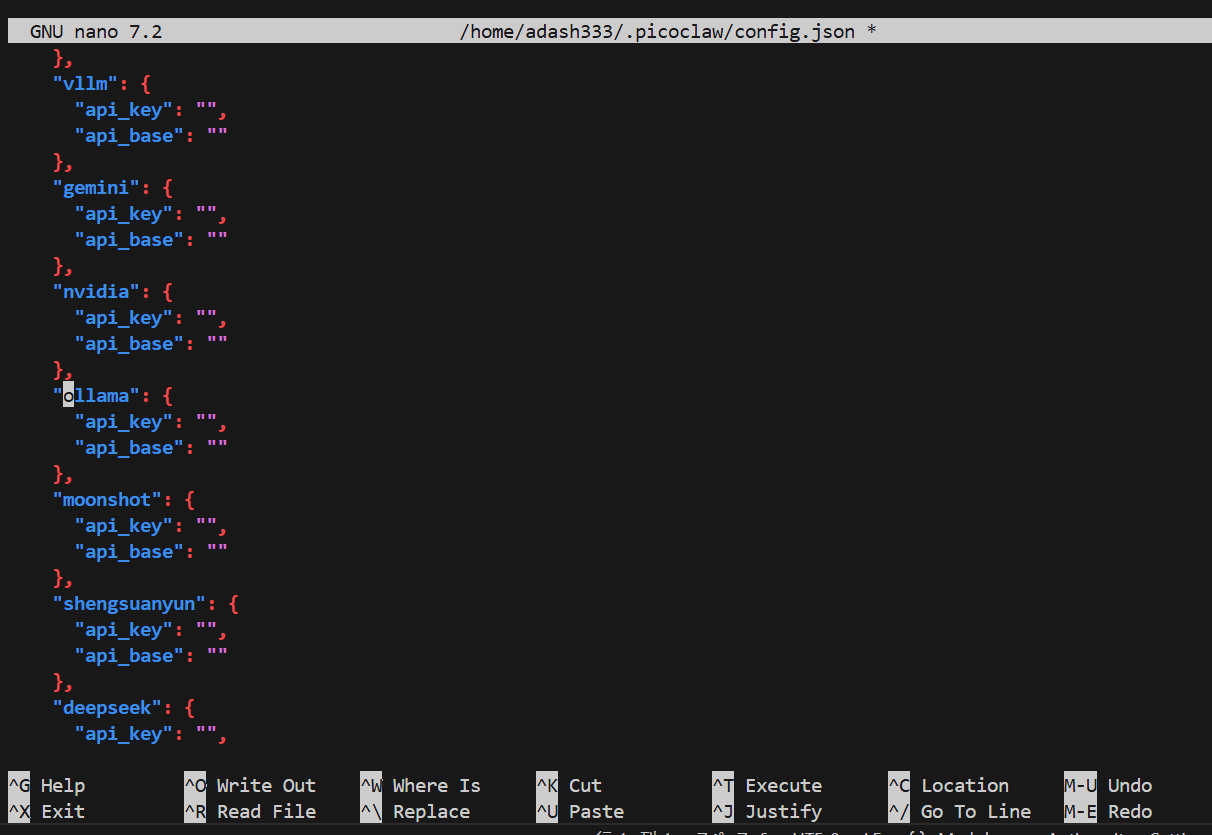

picoclawの初期設定

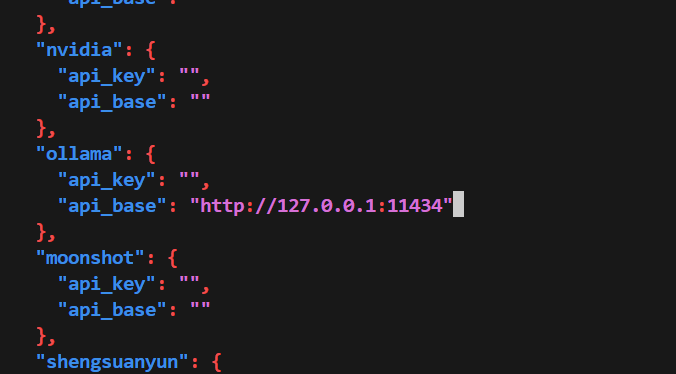

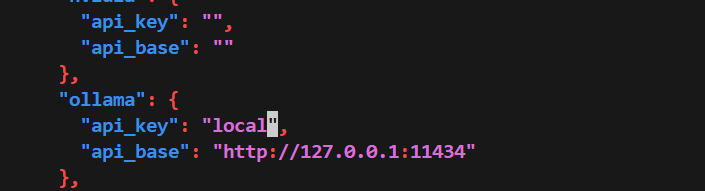

修正前

修正後

さらに、

修正前

修正後

うまくいかない!

すごくたくさんやりましたが、結局、ローカルLLMの反応が遅すぎて、タイムアウトしてしまったりで、うまくいきませんでした。

ローカルLLMあきらめ、、、ChatGPTのAPIを従量課金でやってみたいと思います。とほほ。。。コスト的に、

gpt-4o-mini を考えています。

ディスカッション

コメント一覧

まだ、コメントがありません