(3)モデルの記述

Chainer2でMNIST目次

Chainer2プログラミングの全体図

- (3)モデルの記述(Chainer) ⇐ いまココ

#3 モデルの記述

class MyModel(Chain):

def __init__(self):

super(MyModel,self).__init__(

# パラメータを含む関数の宣言

)

def __call__(self, ...):

# モデルを記載

開発環境

Windows 8.1

Anaconda

Python 3.5

Chainer 2.0

Chainerのインストール方法はChainer2.0をWindowsにインストールをご覧下さい。

このページは、(2)データの準備・設定の続きであり、今回は、MNISTのモデルの記述を行っていきます。

手順

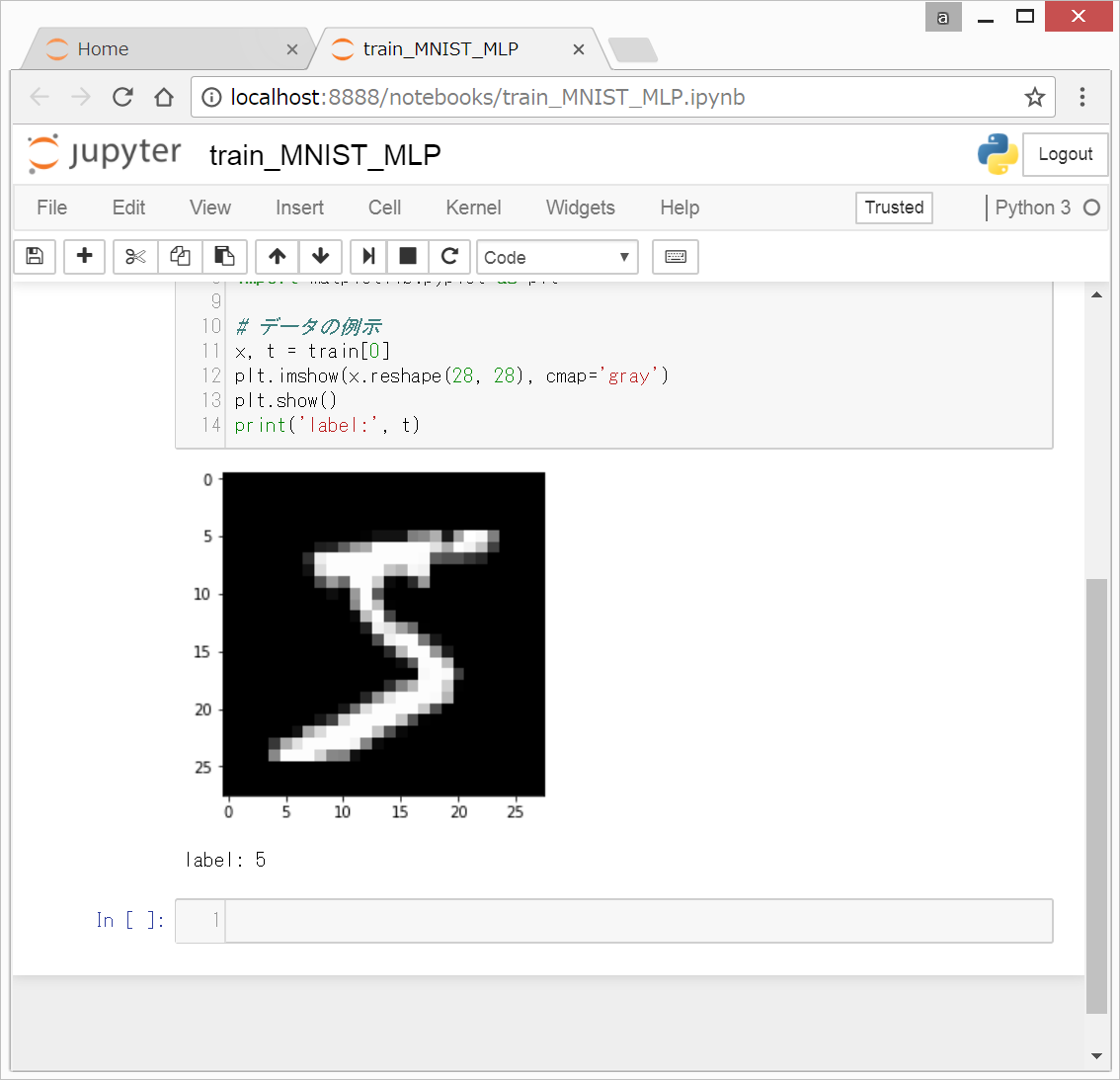

0. 前回終了時の画面

(2)データの準備・設定終了時の、以下のような状態から始めます。

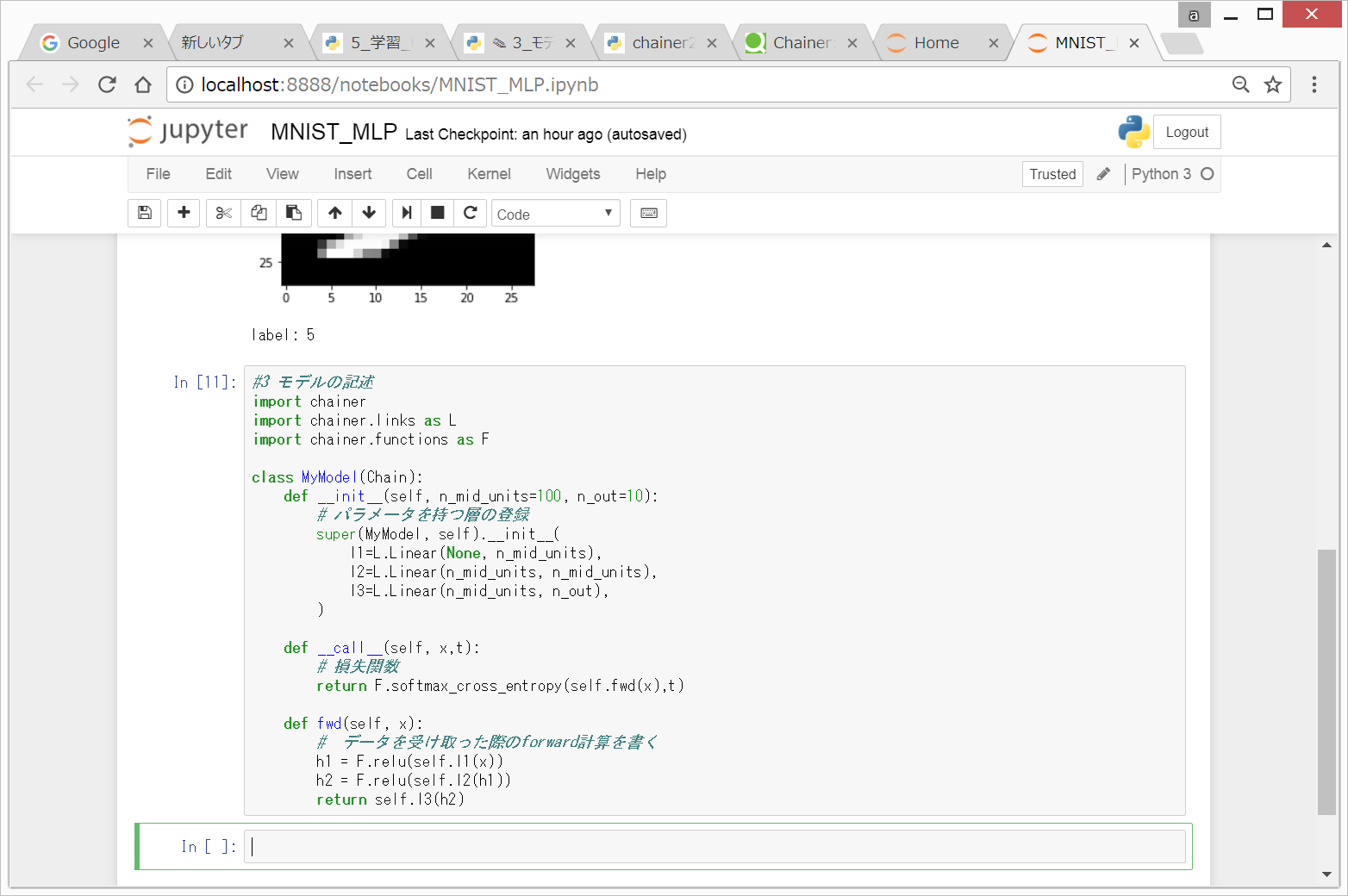

1. モデルの記述

以下のコードを入力して、Shift + Enterを押します。

'''

今回は、手書き数字MNIST画像を、multiple layer perceptron(多層パーセプトロン)という

ニューラルネットワークモデルを用いて機械学習で分類します。

層構造のイメージは、以下のリンクが参考になります。

https://qiita.com/kenmatsu4/items/7b8d24d4c5144a686412

ネットワークは3層で、入力層、隠れ層、出力層の3層とします。

28x28のグレースケール画像を、0から255までの値をとる各ピクセルの値を、

784個、横に並んだ数字の配列に変換して(、さらに255で割って)、

入力層に入れます。入力層のunit数は784個となります。

中間層のunit数(n_mid_units)は、今回は、100個に設定しています。

手書き数字の0から9まで10種類の画像を分類するため、

出力層のunit数(n_out)は、10個となります。

'''

class MLP(chainer.Chain):

def __init__(self, n_mid_units=100, n_out=10):

super(MLP, self).__init__(

l1=L.Linear(None, n_mid_units),

l2=L.Linear(n_mid_units, n_mid_units),

l3=L.Linear(n_mid_units, n_out),

)

def __call__(self, x):

h1 = F.relu(self.l1(x))

h2 = F.relu(self.l2(h1))

return self.l3(h2)

すると、以下のような画面になります。(ほとんど何もおこりません。)

図は作成中

Chainerで、Multiple layer Perceptoronのモデルを記述する作業は上記でおしまいです。

次は、(4)モデルと最適化アルゴリズムの設定に進んでください。

参考文献

Chainer: ビギナー向けチュートリアル Vol.1

mitmul 2017年05月18日に更新

https://qiita.com/mitmul/items/eccf4e0a84cb784ba84a

Chainer2に関しては、以下の本がかなりおすすめです。

<html>

<iframe style=“width:120px;height:240px;” marginwidth=“0” marginheight=“0” scrolling=“no” frameborder=“0” src=“rcm-fe.amazon-adsystem.com/e/cm?lt1=_blank&bc1=000000&IS2=1&bg1=FFFFFF&fc1=000000&lc1=0000FF&t=twosquirrel-22&o=9&p=8&l=as4&m=amazon&f=ifr&ref=as_ss_li_til&asins=B01NBMKH21&linkId=a7a35903a4c55f62d8aa012c3d0277d8”></iframe>

</html>

Deep Learningについての理論については、以下の本が超お勧めです。

<html>

<iframe style=“width:120px;height:240px;” marginwidth=“0” marginheight=“0” scrolling=“no” frameborder=“0” src=“rcm-fe.amazon-adsystem.com/e/cm?lt1=_blank&bc1=000000&IS2=1&bg1=FFFFFF&fc1=000000&lc1=0000FF&t=twosquirrel-22&o=9&p=8&l=as4&m=amazon&f=ifr&ref=as_ss_li_til&asins=4873117585&linkId=603bea27ea1777eb662830c5609200a1”></iframe>

</html>

リンク